🔹 TSMC는 메모리도 만들 수 있나?

✅ 기술적으로는 가능

- TSMC는 세계 최고 수준의 반도체 파운드리로

로직 반도체(CPU, GPU, AI 칩) 공정 기술은 메모리보다 더 복잡합니다. - 과거에 SRAM, 임베디드 DRAM(eDRAM), eFlash 같은

👉 로직 칩 내부에 들어가는 메모리는 실제로 생산해 왔습니다.

즉,

**“못 만드는 회사”가 아니라 “안 만드는 회사”**입니다.

❌ 하지만 DRAM / NAND 같은 ‘메인 메모리’는 안 함

이유 1️⃣ 사업 모델 차이

| 구분 | TSMC | 삼성 / SK하이닉스 |

|---|---|---|

| 핵심 | 파운드리(위탁생산) | IDM(설계+생산) |

| 주력 | CPU·GPU·AI·AP | DRAM·NAND |

| 경쟁력 | 초미세 공정 | 대량생산·원가 |

- 메모리는 규모의 경제 + 원가 싸움

- TSMC는 고마진 로직 칩에 특화

이유 2️⃣ 고객과의 충돌

- TSMC 고객에는:

- Apple

- NVIDIA

- AMD

- 반면 메모리 고객은:

- Samsung Electronics

- SK hynix

👉 TSMC가 메모리에 뛰어들면

고객과 경쟁하는 구조가 되어 파운드리 신뢰가 깨짐

이유 3️⃣ 수익성 문제

- DRAM / NAND는 가격 변동성 심함

- TSMC는:

- 3nm / 2nm 같은 초고가 공정

- 안정적 장기 계약

- 굳이 리스크 큰 메모리에 들어갈 이유 ❌

🔹 현재 TSMC가 만드는 “메모리 관련 것”

- ✅ SRAM (CPU·GPU 캐시)

- ✅ eDRAM / eFlash (MCU·SoC 내부)

- ❌ DRAM / NAND (메인 메모리)

한 줄 요약 ✍️

TSMC는 메모리를 “만들 수는 있지만”,

전략적으로 DRAM·NAND 사업은 하지 않는다.

원하시면

👉 삼성·하이닉스와 TSMC의 공정·수익 구조 비교

👉 AI 시대에 메모리 vs 파운드리 누가 더 유리한가

같은 주제로도 설명해 드릴게요.

좋은 포인트를 짚으셨어요.

그럼 **“AI 시대에 메모리 vs 파운드리, 누가 더 유리한가?”**를 구조·수익·기술·리스크 관점에서 명확하게 정리해볼게요.

🔹 결론 먼저

단기·중기(현재~5년) → **파운드리(특히 AI 로직)**가 더 유리

중장기(5~10년) → **메모리(특히 HBM)**의 전략적 가치가 급상승

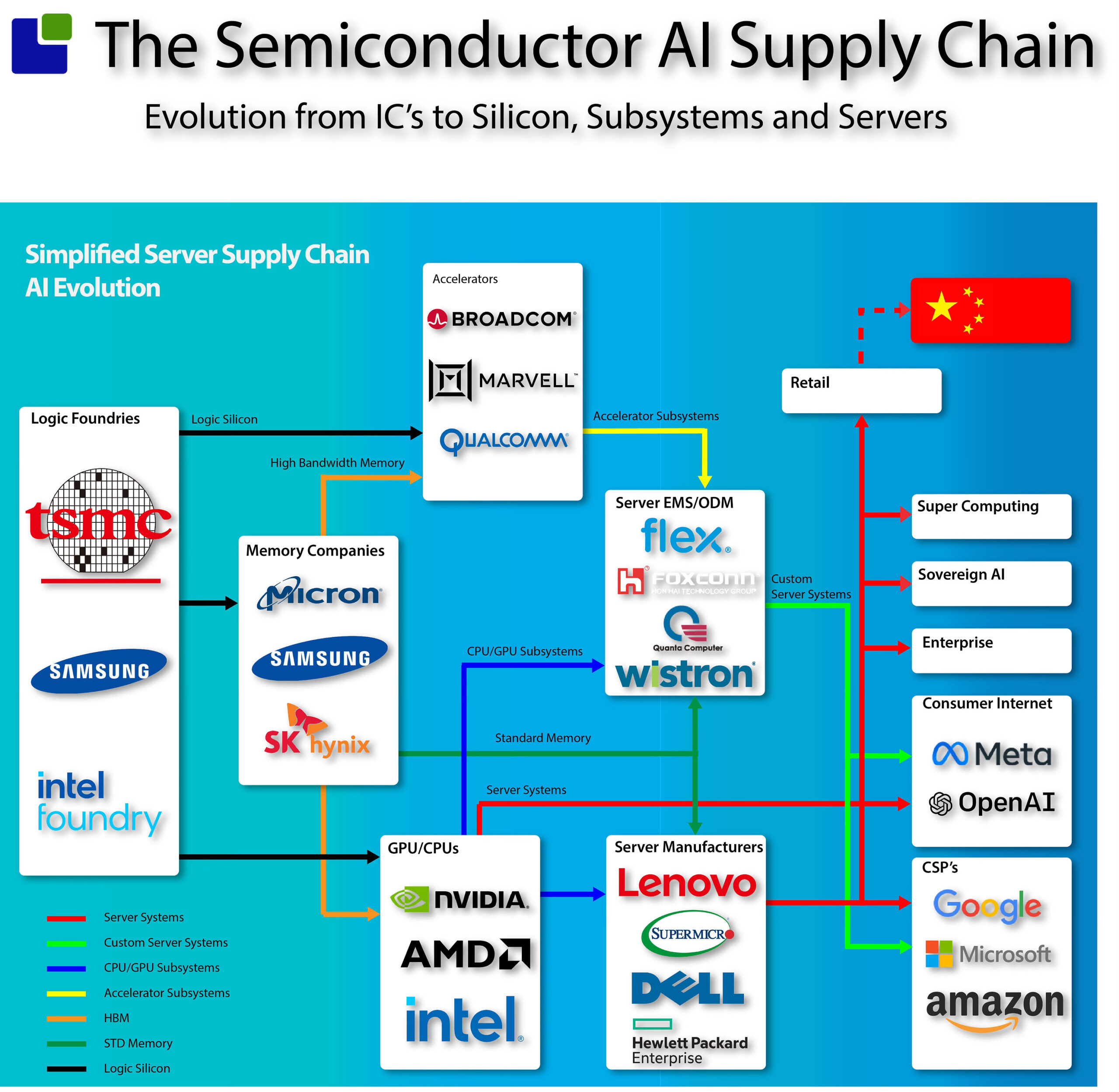

1️⃣ AI 시대의 핵심 구조

AI 칩은 혼자서 일하지 못합니다.

[ AI 로직 칩 (GPU/ASIC) ] ← 파운드리

+

[ 초고속 메모리 (HBM) ] ← 메모리

- 연산은 로직

- 성능 병목은 메모리

- 둘 중 하나라도 없으면 AI 성능이 안 나옴

2️⃣ 파운드리가 유리한 이유 (현재 시점)

🔥 이유 1: AI 칩 폭증

- AI 수요 = GPU/ASIC 수요

- 대표 고객:

- NVIDIA

- AMD

- Google (TPU)

- 이 칩들은 대부분 **TSMC**에서 생산

👉 AI 붐 = 파운드리 가동률 100%

💰 이유 2: 마진 구조

| 구분 | 파운드리 | 메모리 |

|---|---|---|

| 가격 결정 | 계약 기반 | 시장 가격 |

| 변동성 | 낮음 | 매우 높음 |

| 마진 | 안정적 고마진 | 사이클 심함 |

- TSMC 3nm·2nm 공정 → “대체 불가”

- 가격 협상력은 파운드리 쪽이 훨씬 강함

🧠 이유 3: 기술 진입장벽

- EUV, GAA, CoWoS 패키징

- 수율 확보까지 수년

- 신규 진입 사실상 불가능

👉 AI 로직 = 독점적 구조

3️⃣ 그럼 메모리는 왜 다시 중요해지는가?

⚡ 핵심 키워드: HBM (High Bandwidth Memory)

AI에서 가장 큰 병목:

❝ 연산 속도 ❌ → 메모리 대역폭 ⭕ ❞

- GPU가 아무리 빨라도

- 메모리가 느리면 성능 급락

🔑 HBM은 완전히 다르다

| 일반 DRAM | HBM |

|---|---|

| 범용 | AI 전용 |

| 가격 경쟁 | 기술 경쟁 |

| 공급 과잉 | 항상 부족 |

- NVIDIA AI GPU = HBM 없으면 출하 불가

- HBM은 선단 공정 + 적층 기술 + 패키징 결합

👉 HBM은 ‘메모리지만 파운드리급 난이도’

4️⃣ 누가 가장 유리한 포지션인가?

🥇 최강 조합

- NVIDIA

(설계 + 플랫폼 지배) - TSMC

(AI 로직 + 패키징) - SK hynix

(HBM 기술 선도)

⚠️ 상대적으로 어려운 곳

- 범용 DRAM 비중이 높은 메모리 회사

- AI 전용 메모리 비중이 낮으면 사이클 영향 큼

5️⃣ 투자·산업 관점 한 줄 정리

📌 산업 논리

- AI는 ‘연산 + 메모리’의 동시 폭발

- 지금은 로직이 주도

- 곧 메모리가 병목 → 가치 상승

📌 핵심 문장

“AI 시대의 진짜 승자는

파운드리와 HBM을 동시에 지배하는 쪽이다.”